mir ist an zwei Stellen aufgefallen, dass die interne InfluxDB des Timberwolf Servers Probleme damit hat, wenn Werte gleichzeitig (oder fast gleichzeitig) ankommen.

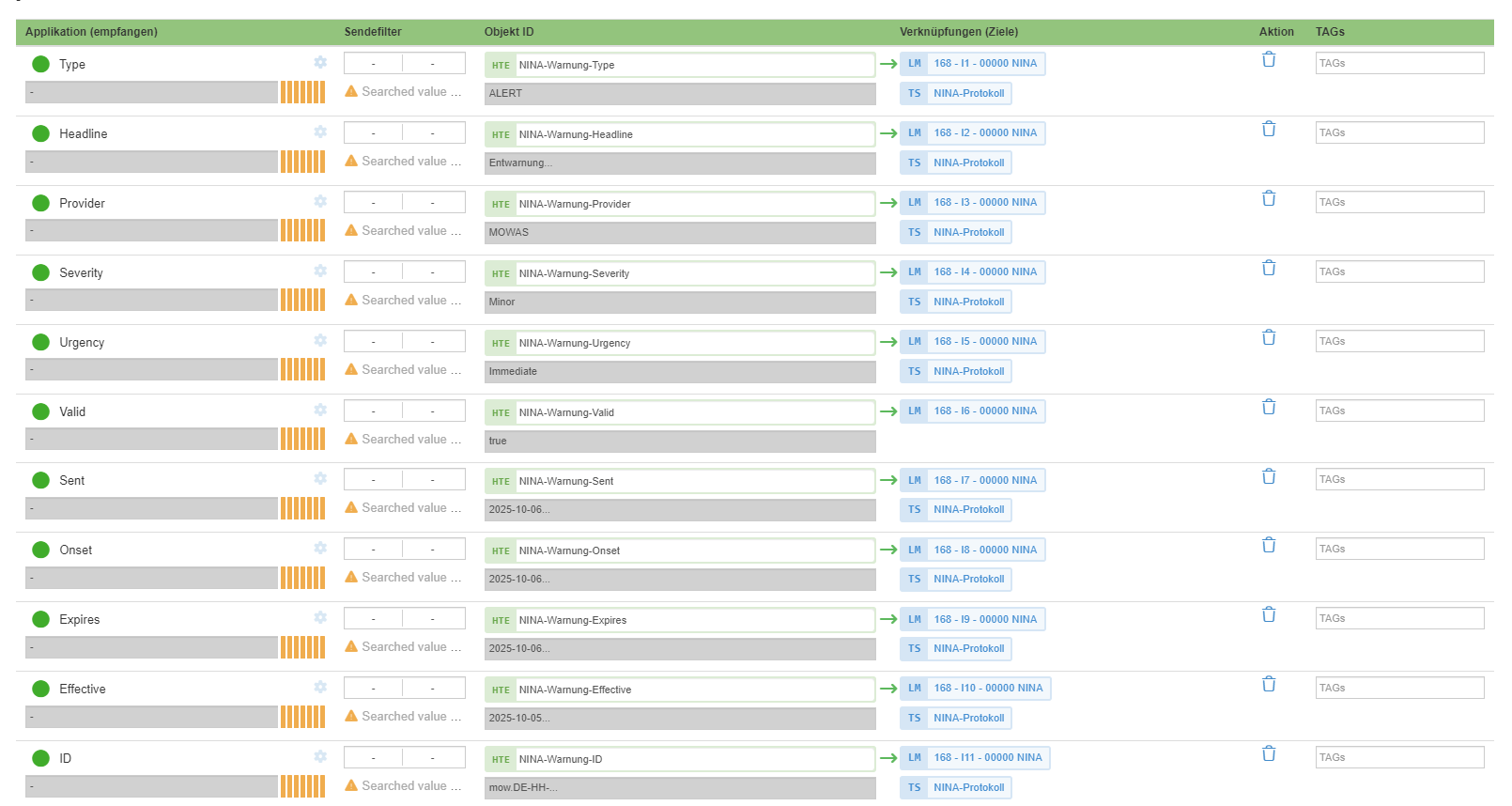

Ich beschäftigte mich gerade damit, NINA-Warnungen per REST-API abzufragen und auszuwerten. Um herauszufinden, ob die HTTP-Auswertungen der einzelnen JSON-Selektoren bei jeder Serverabfrage in der gleichen Reihenfolge (in der Reihenfolge der Abfragen in der UI) über den Dispatcher verschickt werden, habe ich alle Abfragen mit einer Zeitreihe namens NINA-Protokoll verknüpft:

Selbst wenn eine NINA-Warnung vorliegt und alle Auswertungen mit Werten versehen werden, werden diese nicht immer in die Zeitreihe geschrieben.

Ich vermute daher, dass das damit zusammenhängt, dass die Werte - wenn nicht exakt gleichzeitig - aber doch mit so geringem Zeitabstand eintreffen, dass die InfluxDB damit überfordert ist. Es wurden nämlich auch nicht immer die gleichen Werte gespeichert, das geschieht mehr oder weniger zufällig.

An anderer Stelle hatte ich das gleiche Phänomen mit MQTT-Werten. Im Rahmen meiner Heizungssteuerung Viessmann über MQTT (viewtopic.php?p=63486&hilit=viessmann#p63486) habe ich eine Logik, die mehrere Befehle für die Heizung erstellt und diese über mehrere Ausgänge an das entsprechende MQTT-Objekt schickt. Die Ausgänge der Logik werden beim Ausführen natürlich nicht exakt gleichzeitig beschrieben, aber in nicht messbaren Zeitabständen. Über MQTT wurden alle Befehle der Reihe nach verschickt und vom Optolink-Splitter verarbeitet. Aber (vor allem zu Testzwecken) schreibe ich alle Aktivitäten auf diesem MQTT-Topic in eine Zeitreihe, und dort fehlten auch immer wieder Einträge (im MQTT-Explorer waren diese in der Historie sichtbar).

Liegt das an einer "Überforderung" der InfluxDB bei zu schnell hintereinander eintreffenden Werten? Der TWS-Dispatcher ist offensichtlich zu schnell für die InfluxDB?

Vielen Dank und viele Grüße

Falk